生成式 AI 涉及哪些資安風險?AI 資料安全與防護方法介紹

部落格 / 生成式 AI 涉及哪些資安風險?AI 資料安全與防護方法介紹

你有否想過當你與 AI 代理互動時,系統可能正學習你的個人資訊,收集及分析本應受保護的敏感資料?使用生成式 AI 所隱含的資安風險,不單涉及個人私隱,亦可能影響企業運作及法規責任,現時已成為 AI 資訊安全領域的重點議題。本文由 OneAsia 帶你深入瞭解應用 AI 時可能面臨的資料安全問題,並提供防護方法,助你在享受 AI 帶來便利的同時,亦能保障資料的安全。

什麼是生成式 AI 資安風險?

根據香港私隱專員公署(PCPD)2025 年對 60 間本地機構的調查,現時有 80% 的機構在業務中會使用 AI,當中 50% 的機構會透過 AI 系統收集及使用個人資料 [1],足見 AI 資料安全已成為企業營運中不可忽視的課題。所謂生成式 AI 資安風險,是指人工智能於開發、部署與使用過程中,可能出現的各類安全威脅,例如提示詞注入攻擊,誘騙 AI 洩漏敏感資料、模型遭惡意入侵篡改程式碼,使 AI 回覆出現錯誤資訊等。由於生成式 AI 強調自我學習及模型優化,其決策過程往往不透明並複雜,因此於訓練時不單須保護敏感資料,亦須確保模型完整性及系統安全性。

生成式 AI 的資安風險分類

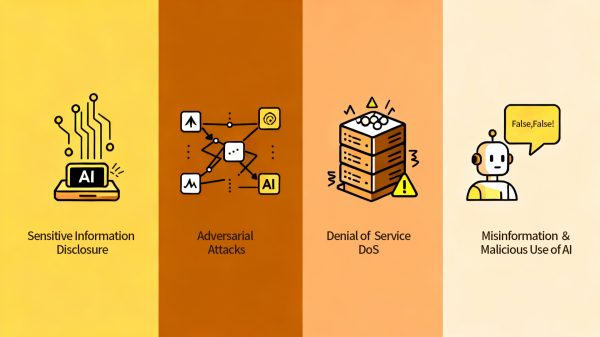

隨著生成式 AI 技術的發展,國際上陸續提出多種 AI 資安風險分類,其中較為常見包括 NIST、OWASP、MITRE ATLAS 及 ENISA 等。綜合各方觀點,生成式 AI 的資安風險大致可分為以下 4 大類別:

資料外洩(Sensitive Information Disclosure)

資料外洩是 AI 資安風險中最普遍的一種,指在開發或部署 AI 系統過程中,私隱資料如個人身份資訊、醫療紀錄、財務資料或企業機密,被未授權的第三方存取、竊取或公開。在生成式 AI 應用中,這些資安風險可能源自模型訓練階段的數據處理不當,或系統本身存在漏洞。

模型受攻擊(Adversarial Attacks)

模型受攻擊亦為生成式 AI 的另一重要資安風險,攻擊者可能藉由輸入惡意數據或操控資料,令 AI 模型產生錯誤判斷或洩露敏感資訊。根據 MITRE ATLAS 的分類 [2],常見的模型攻擊行為包括:

- 對抗性樣本(Adversarial Examples):在輸入中加入細微及難以覺察的變化,誤導模型做出錯誤判斷,例如調整圖像像素、語音波形或語言表達。

- 提示注入(Prompt Injection):在輸入指令或外部資源中嵌入惡意命令,誘使模型違背原有規範或洩漏私密信息。

- 數據中毒(Data Poisoning):故意在模型訓練或微調階段注入錯誤或惡意數據,破壞模型的準確性與穩定性。

- 模型竊取(Model Extraction / Theft):攻擊者透過不斷查詢模型 API 接口,收集輸入及輸出的資料,來訓練「替代模型」。若企業委任未授權的第三方製作 AI 模型,可導致資料安全問題,或甚至企業之產權受損。

- 模型逆推(Model Inversion):利用模型回應推斷曾參與訓練的數據特徵,重建或還原個人私隱資料。

系統服務中斷(Denial of Service,DoS)

由於生成式 AI 在推理及訓練過程中需大量運算資源輔助(如 GPU、網絡頻寬及雲端基礎設施),若遇到惡意或非預期攻擊,有機會導致系統服務表現下降,甚至完全中斷,成為 AI 資安風險中影響運營穩定性的主要威脅。造成系統服務中斷常見原因包括:

- 高頻查詢攻擊(Query Flooding):攻擊者發送大量請求,令 AI 模型過度運算,造成處理延遲或系統癱瘓。

- API 濫用(API Abuse):生成式 AI 多以 API 方式提供服務,若驗證機制不足,容易被自動化程式(機械人)大規模調用,導致資源耗盡。

- 基礎設施過載(Infrastructure Overload):雲端或共享運算環境下,CPU、記憶體或網絡頻寬遭攻擊後系統滿載,無法正常回應用戶請求。

- 服務依賴攻擊(Dependency or Supply-chain Attack):針對 AI 模型依賴的外部平台,如雲端供應商、金鑰管理、第三方組件及開源套件等發起攻擊,令主要系統受牽連而暫停運作,對採用 AI 運營的公司資料安全構成威脅。

假資訊及內容濫用(Misinformation &Malicious Use of AI)

生成式 AI 資安風險亦包括詐騙範疇,2024 年香港發生一宗震驚全球的案件,一名跨國公司員工在視訊會議中,被詐騙者利用 AI deepfake 技術偽造的影像及聲音誤導,錯以為真實會議指示,結果匯出逾 2 億港元至多個銀行賬戶 [3]。這一案件顯示生成式 AI 除了存在資料外洩風險,亦可能被惡意運用於生成假資訊及內容,導致財務等方面的損失。

傳統資安風險與 AI 資安風險的差異

| 類別 | 傳統資安風險 | AI 資安風險 |

|---|---|---|

| 攻擊目標 | 網絡、資料庫等傳統系統資源 | AI模型本身、訓練數據及生成內容 |

| 行為可預測性 | 多為明確規則,較易檢測 | 模型具學習及自我優化功能,行為具不確定性 |

| 資料來源性質 | 通常為結構化攻擊、來源明確 | 大量非結構化數據,來源複雜 |

| 攻擊範圍 | 多為防火牆、網絡邊界 | 模型 API、第三方模型、外部資料來源等 |

由於傳統資安風險重點在系統及網絡防護層面,而生成式 AI 資安風險涉及模型、數據及算法等多個層面,受攻擊範圍更廣並難以預測影響範圍。因此,保障 AI 資料安全除強化基礎設施外,還需納入模型訓練過程、第三方模型應用以及外部資源的安全管理。

AI 資料安全及防護策略

面對各類生成式 AI 資安風險,建議採取分層防護策略,提升資料及系統的整體安全:

資料治理及權限控管(Data Governance & Access Control)

企業應根據不同類型資料(如個人資料、機密商業資訊、模型訓練數據)進行分類及標註,並建立完善的資料的授權制度,確保只有經授權的員工可存取或修改重要數據。同時,必須採用資料加密、傳輸安全協定(如 TLS/SSL),以及資料存取審核機制,防止未授權的存取或外洩事件。

模型安全與對抗防禦(Model Security & Adversarial Defense)

為防止 AI 模型被誤導或受控導致錯誤判斷,企業應定期測試模型在面對異常或惡意輸入時的表現,及早發現潛在風險。同時,建立持續監控系統,實時追蹤模型運作情況,發現異常時能及時糾正,維護 AI 資料安全。

資源與流量限制(Rate Limiting / Resource Isolation)

實施流量限制(Rate Limiting) 及資源隔離(Resource Isolation)有助降低 AI 模型暴露於高頻查詢或大量 API 調用時的風險。企業可根據用戶身分、用途或風險分級,設定請求上限,並設置負載平衡及異常流量監測機制,避免 AI 系統出現資安風險。

供應鏈與第三方管理(Supply-chain Risk Management)

現時,AI 系統多採用代理式 AI(Agentic AI)的系統設計架構,整合外部工具或第三方服務。因此,必須對相關資源進行嚴格安全評估,定期檢查雲端平台、開源套件等合規性及安全性,以確保系統不受外部威脅影響。

輸出內容過濾與驗證(Output Filtering / Content Verification)

生成式 AI 資安風險多源於其強大的內容生成能力,往往被用來製作虛假訊息或詐騙內容。因此,應設立內容過濾(Content Filtering)、輸出審核(Output Moderation)及事實驗證(Fact Verification)等機制,保障這類具誤導性的 AI 資安風險。此外,建議凡經 AI 自動生成的內容,應清晰標示為「AI 生成內容」,讓用戶明確辨識資訊來源。

守護 AI 系統安全 選擇信任平台

面對生成式 AI 帶來的資安風險,無論是資料外洩、模型受攻擊、系統中斷或內容濫用,每個層面的風險皆可能對機構營運及品牌聲譽造成深遠影響。為維護 AI 資料安全,企業可從制度規劃、技術防護及使用安全平台三方面入手,建立清晰的資料管理制度、採用可靠的安全技術。

OneAsia 安全運營中心 (SOC) 可全天候監察 AI 系統運作,包括模型 API、資料存取行為及雲端流量,偵測異常請求或潛在攻擊;我們亦提供雲端管理服務,統一管理 AI 應用及資料,涵蓋用戶權限、加密措施及 API 存取設定,確保資料傳輸安全可追蹤,同時有效分配計算資源,避免系統因高流量或模型推理負載而中斷。如對 AI 部署安全有任何疑問,歡迎隨時聯繫 OneAsia,打造企業專屬的 AI 就緒數據中心。

資料來源:

- PCPD – The Privacy Commissioner’s Office has Completed Compliance Checks on 60 Organisations to Ensure AI Security

- MITRE ATLAS – Techniques

- The Guardian – Company worker in Hong Kong pays out £20m in deepfake video call scam

- HKU Business School – AI騙案勢暴增 預防中伏靠AI

- HK01 – AI 的陰暗面:揭露新興的網絡安全威脅(蘇仲成)

- Ta Kung Wen Wei Media – 城大用AI拆解網騙作案手法

- Information Security Magazine Taiwan – 生成式 AI 時代的資安防禦策略